Puzzles, juegos interactivos, misteriosas señales. Eso y más encontramos en las redes y la web…

Música generada por IA: ¿Evolución o retroceso?

A propósito de un sinfín de ejemplos de música creada por inteligencia artificial que además se ha vuelto viral en las últimas semanas, quisimos adentrarnos más en este fenómeno

La IA puede generar nueva música que se inspira o incorpora elementos de canciones existentes, pero es un proceso que va más allá de «grabar» lo que escucha de diversos servicios de streaming. De entrada, hay varios enfoques que los modelos de IA pueden usar para crear canciones a partir de muestras de música. Por ejemplo Generative Adversarial Networks (GAN), redes antagónicas generativas en español; son un tipo de modelo de aprendizaje automático que se puede usar para generar nuevos datos, como imágenes, videos o incluso música. Están compuestos por dos redes neuronales: un generador y un discriminador.

El generador es responsable de crear nuevos datos a partir de información ingresada incluso de manera aleatoria. El discriminador, por otro lado, está entrenado para distinguir entre datos reales y generados. Las dos redes se entrenan (¿enfrentan?) simultáneamente, con el generador tratando de engañar al discriminador para que piense que sus datos generados son reales, y el discriminador tratando de identificar correctamente si los datos que está viendo son reales o generados. A través de este proceso de competencia y retroalimentación, el generador aprende a crear datos más realistas, mientras que el discriminador mejora en la identificación de datos falsos. No obstante, las GAN pueden ser difíciles de entrenar y requieren grandes cantidades de recursos computacionales.

En el caso de la música, la red del generador se entrena en un gran conjunto de datos de muestras de música y crea música nueva generando muestras aleatoriamente y enviándolas al discriminador. La red discriminadora evalúa la música generada y determina si es «real» (es decir, del conjunto de datos original) o «falsa» (es decir, generada por la red generadora). Luego, la red del generador ajusta sus parámetros para intentar crear música más realista y el proceso se repite.

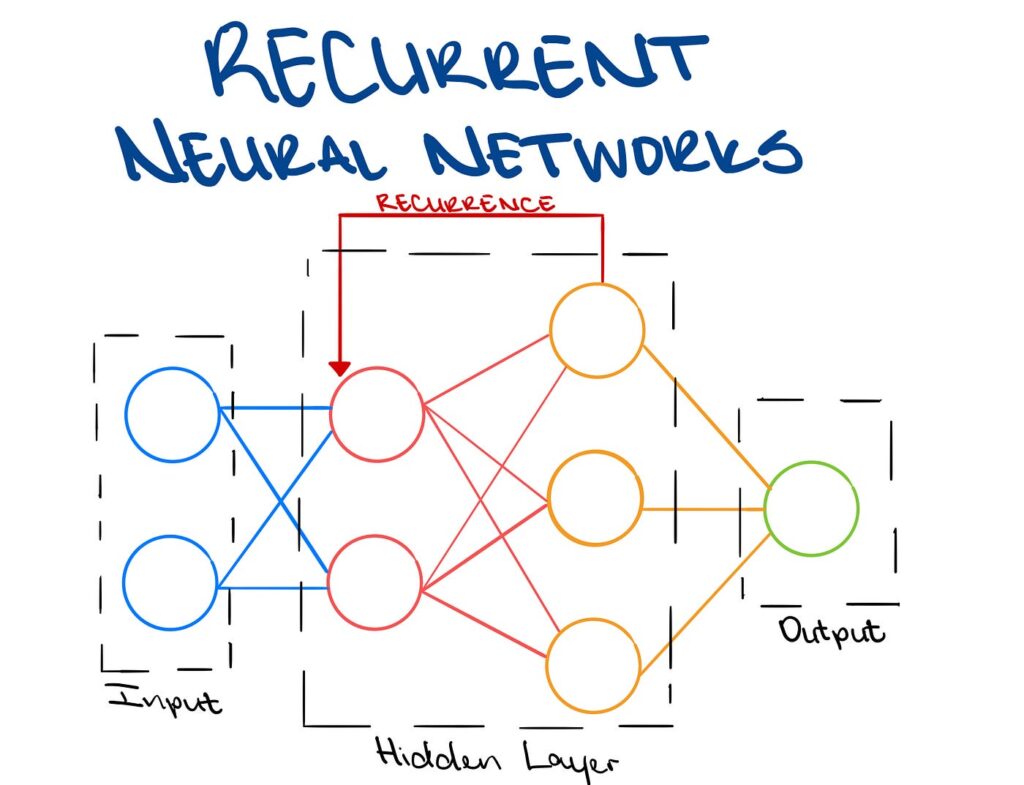

Otro enfoque probable en la IA es el uso de Recurrent Neural Networks (RNN), redes neuronales recurrentes. Es a grandes rasgos, un tipo de programa informático que puede ayudar a las computadoras a aprender a partir de secuencias de datos. Estos programas se utilizan en muchas aplicaciones, como la traducción de idiomas, el reconocimiento de voz e incluso la predicción del tiempo. Ayudan a las computadoras a comprender secuencias de datos y hacer predicciones basadas en lo que han aprendido de esa secuencia.

Los RNN son particularmente útiles para generar música porque pueden aprender a reconocer patrones en secuencias de notas y ritmos. El modelo se entrena en un conjunto de datos de música y luego genera nueva música mediante el muestreo de su distribución de probabilidad aprendida sobre esas notas y ritmos. Aunque en la mayoría de los casos recientes y virales de música generada por IA, se desconoce el modelo específico utilizado, es probable que haya sido entrenado con un gran conjunto de datos y luego se haya utilizado uno de los enfoques anteriores para generar una nueva canción en su estilo.

¿Pero esta música es avance o retroceso?

La tecnología reconoce el estilo propio de un artista, sus entonaciones, modulaciones, elección de notas, acordes, melodías y ritmos, trata de emular ese estilo y no se separa de él, pero hay artistas que precisamente tratan de reinventarse, pensemos en David Bowie, sin darle ninguna información previa ¿sería capaz la IA de reconocer que la misma persona hizo «Honky Dory», «Earthling» o «Black Star»?

En una entrevista con The Guardian, Bobby Geraghty y Chris Woodgates, músicos ingleses integrantes de Breezer, comentaron que se hartaron de esperar una reunión de Oasis, se cansaron de la pelea entre los hermanos Gallagher y decidieron usar su propia música pero agregando a Liam de manera artificial. Su música estaba altamente influenciada por la etapa 95-97 de Oasis pero no había tenido éxito, así que comenzaron a alimentar un modelo de IA con todo el catálogo de Oasis y varias grabaciones a capella de Liam. Por un momento incluso pensaron en lanzar el álbum de 33 minutos como si fuera una grabación perdida de los originales Oasis, pero se contuvieron.

Quizá en un futuro inmediato, una forma de evitar que la música generada por IA se presente como hecha por un artista específico es etiquetarla claramente cómo generada por IA o acreditar el modelo de IA que generó la música. Esto se puede hacer en los metadatos del archivo de audio o en los créditos del álbum o canción. Algunas plataformas de música, como YouTube y SoundCloud, tienen políticas vigentes que requieren que los creadores revelen cuándo su contenido se generó con IA.

Seguramente el canal «AI Remixes» en YouTube cumple con esta obligación. Su especialización es usar la voz generada por IA de Kurt Cobain, Chad Bennington y otros famosos para realizar covers de Radiohead, Soundgarden, Slipknot y R.E.M. por mencionar tan solo algunos ejemplos. ¿Hay más mérito en esto o en un imitador en un programa de televisión?

Desde una perspectiva técnica, también puede haber formas de incluir huellas digitales en la música generada por IA que podrían ayudar a identificarla como tal. Por ejemplo, las técnicas de marca de agua podrían usarse para añadir información en el archivo de audio que indica que fue generado por un modelo de IA específico o por una organización en particular. Sin embargo, este enfoque requeriría un acuerdo y coordinación entre la industria de la música, los investigadores de IA y los proveedores de tecnología para establecer una forma estándar de incorporar estas huellas y detectarlas.

Actualmente no existe un requisito legal para que la música generada por IA esté claramente etiquetada o acreditada y no existen estándares técnicos establecidos para incorporar huellas digitales en la música generada por IA, por lo tanto, depende en gran medida de la buena voluntad y las prácticas éticas de los desarrolladores de IA, los productores de música y las plataformas para garantizar que la música generada por IA no se tergiverse como creada por un artista o grupo específico.

Recordemos que recientemente «Heart on My Sleeve» una canción generada por IA, que copiaba las voces y estilos de Drake y The Weeknd se volvió viral en diversas redes sociales, acumulando millones de reproducciones en TikTok, Spotify y YouTube hasta que fue eliminada por las repercusiones monetarias que causó.